Многие владельцы сайтов, особенно те, кто занимается оптимизацией поисковой системы (SEO), наверняка слышали о файле robots.txt. Но что это за файл и зачем он нужен?

Robots.txt — это текстовый файл, который размещается на сайте и предназначен для информирования поисковых роботов о том, как индексировать и сканировать сайт. Он сообщает роботам, какие страницы можно индексировать, а какие следует игнорировать.

Использование robots.txt позволяет вам контролировать доступ поисковых роботов к определенным страницам вашего сайта. Например, вы можете запретить роботам индексацию и сканирование страниц с конфиденциальной информацией или страницы с дублирующимся содержимым.

Robots.txt является важным элементом оптимизации поисковой системы, так как позволяет вам управлять процессом индексации вашего сайта и предотвращать индексацию нежелательных страниц. Правильное использование robots.txt помогает улучшить видимость вашего сайта в поисковых системах и рост органического трафика.

Что такое robots.txt?

Файл robots.txt располагается в корневой директории веб-сайта и содержит инструкции для роботов, таких как Googlebot, о том, как обходить страницы и папки на сайте. Этот индексный файл определяет, какой контент должен быть доступен для индексации поисковыми системами, и позволяет исключить конкретные разделы, которые не должны быть отображены в поисковой выдаче.

Структура файла robots.txt

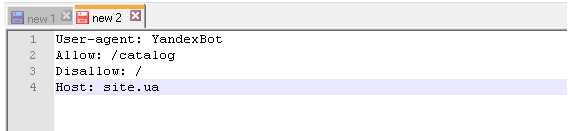

Структура файла robots.txt состоит из нескольких элементов. Самый основной элемент – это «User-agent», который указывает на конкретного поискового робота или группу роботов, к которым применяется данная инструкция. В индексном файле также присутствует директива «Disallow», которая указывает на запрет доступа к определенным страницам или разделам сайта.

Файл robots.txt может быть очень полезным для оптимизации SEO, так как он позволяет повлиять на то, какие страницы будут индексироваться поисковой системой. Он также используется для указания сайту или поисковой системе на наличие других файлов, таких как карты сайта (sitemap.xml), которые помогают поисковым роботам лучше проиндексировать контент на сайте.

- User-agent: указывает на поискового робота, которому применяется инструкция

- Disallow: запрещает доступ к определенным страницам или разделам сайта

- Allow: указывает, какие страницы или разделы сайта доступны для индексации

- Sitemap: указывает путь к файлу карты сайта на сервере

Назначение и функции файла robots.txt

Файл robots.txt может быть полезен для сайтов, которые хотят ограничить доступ к некоторым частям своего контента или директорий, а также для предотвращения индексации дублирующего контента, несущественных страниц, динамических параметров и других компонентов сайта, которые не являются важными для SEO или могут негативно влиять на позиции сайта в поисковой выдаче.

Файл robots.txt обычно используется для следующих целей:

- Запрет индексации конкретных частей сайта;

- Ограничение доступа к определенным каталогам или страницам сайта;

- Укажите местоположение файла sitemap.xml;

- Управление сканерами и поисковыми роботами;

- Предотвращение индексации некоторых типов файлов, таких как PDF, изображения, архивы и т.д.

Как работает robots.txt?

В основе работы robots.txt лежит простой принцип — роботы поисковых систем перед тем, как начать процесс индексации сайта, проверяют наличие файла robots.txt и читают его содержимое. Если в файле есть инструкции относительно конкретной страницы или каталога сайта, роботы действуют согласно этим инструкциям. Если же файла нет или в нем нет инструкций для конкретной страницы, роботы проходят без ограничений и индексируют все доступные им страницы.

Файл robots.txt состоит из команд, каждая из которых указывается на новой строке. Основная команда — «User-agent», которая определяет робота, к которому применяется данная инструкция. Затем идет команда «Disallow», которая указывает на файлы и каталоги, которые роботам запрещено индексировать. Также можно использовать команду «Allow», которая разрешает роботам индексировать определенные файлы или каталоги сайта. Комментарии в файле robots.txt начинаются с символа «#» и игнорируются роботами.

Robots.txt – это мощный инструмент для управления индексацией сайта поисковыми системами. С его помощью можно разрешить или запретить индексацию конкретных разделов сайта, правильно настроить работу поисковых роботов и избежать индексации нежелательных страниц. Также файл robots.txt помогает ускорить процесс индексации сайта и улучшить его видимость в поисковых системах. Вместе с тем, неправильное написание или неправильное размещение файла может привести к проблемам в индексации сайта и негативно сказаться на его видимости в поисковых системах.

Зачем нужен индексный файл?

Индексный файл позволяет веб-мастерам ограничивать индексацию определенных страниц и директорий на их сайте. Это может быть полезно, если у вас есть конфиденциальная информация, которую вы не хотите показывать в поисковых результатах, или если вы хотите предотвратить сканирование чувствительных данных поисковыми роботами.

Индексный файл также может использоваться для указания поисковым роботам, какие файлы или директории они должны игнорировать при индексации. Например, вы можете указать поисковым роботам не индексировать папку с административным интерфейсом вашего сайта, чтобы предотвратить доступ к конфиденциальным данным или уязвимостям.

Кроме того, индексный файл может содержать ссылки на карту сайта, которая помогает поисковым системам понять структуру вашего сайта и более эффективно индексировать его страницы. Это особенно важно для больших и сложных сайтов, где поисковым роботам может потребоваться помощь в определении наиболее важных страниц для индексации.

В целом, индексный файл играет важную роль в SEO-оптимизации, позволяя веб-мастерам контролировать индексацию и доступность своих сайтов для поисковых систем. Он предоставляет возможность управлять тем, что видят поисковики и как они взаимодействуют с вашим сайтом, что является важным элементом успешной поисковой оптимизации.

Ограничение доступа к страницам сайта

В файле robots.txt используются различные инструкции и директивы, которые сообщают роботам, как вести себя на сайте. Самая распространенная директива — «Disallow», которая указывает роботу не заходить на определенную страницу или папку. Это может быть полезно, например, для скрытия конфиденциальной информации, временно закрытого контента или страниц, которые требуют авторизации пользователя.

Примеры использования robots.txt

Допустим, у нас есть страница с адресом «https://www.example.com/confidential-page.html», которую мы хотим скрыть от поисковых роботов. В таком случае мы можем добавить следующую строку в файл robots.txt:

Disallow: /confidential-page.html

Таким образом, поисковые роботы будут игнорировать эту страницу и не будут ее индексировать.

Также, мы можем указать расширение файлов, которые необходимо исключить из индексации. Например, для исключения всех файлов с расширением «.pdf» можно добавить следующую строку:

Disallow: /*.pdf

В этом случае все файлы с расширением «.pdf» не будут индексироваться поисковыми роботами.

Повышение производительности сайта

Существует несколько способов повысить производительность сайта:

1. Оптимальная работа кода

Важно создать оптимизированный код, который будет выполняться быстро и эффективно. Это включает в себя минимизацию и сжатие стилей CSS и скриптов JavaScript, а также удаление неиспользуемого кода. Кроме того, необходимо использовать кэширование, чтобы сохранять некоторые данные на стороне клиента, что позволит увеличить скорость загрузки страницы.

2. Оптимизация изображений

Одной из основных причин медленной загрузки страниц являются изображения большого размера. Для повышения производительности сайта необходимо оптимизировать изображения, то есть изменить их размеры и форматы, чтобы они занимали меньше места на сервере и загружались быстрее. Также стоит использовать сжатие без потерь качества изображений.

3. Кэширование

Кэширование помогает сохранить некоторые данные на стороне клиента, чтобы при повторном обращении к сайту не нужно было выполнять одни и те же операции или загружать одни и те же данные снова. Кэширование позволяет сократить время загрузки страницы и увеличить производительность сайта.

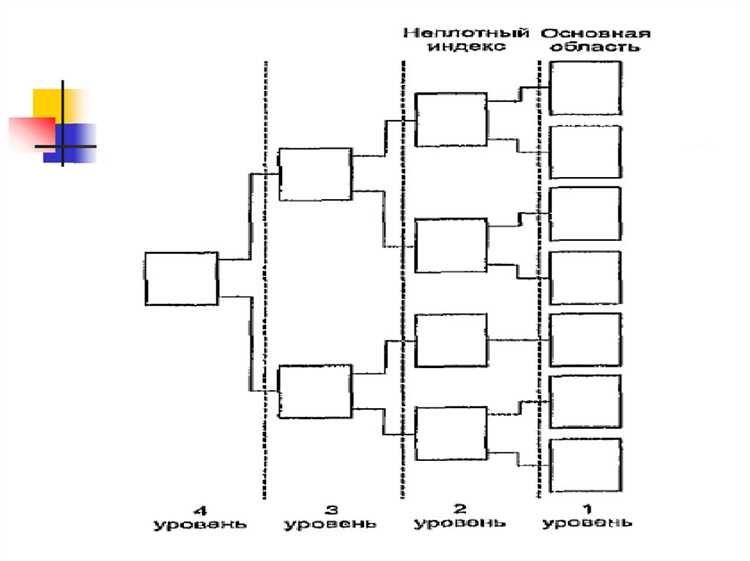

4. Оптимизация базы данных

База данных является одной из основных компонентов сайта, и ее оптимизация может существенно повысить производительность. Для этого можно использовать различные методы, такие как удаление ненужных данных, оптимизация запросов, индексирование таблиц и многое другое.

5. Использование Content Delivery Network (CDN)

CDN — это глобальная сеть серверов, которая помогает ускорить доставку контента на сайт. Она расположена ближе к пользователям и позволяет сократить время загрузки страницы за счет распределения ресурсов по разным серверам.

Это лишь некоторые из методов, которые могут быть использованы для повышения производительности сайта. Однако, выбор конкретных методов всегда зависит от конкретной ситуации и специфики сайта.

Указание на сайтов карты сайта

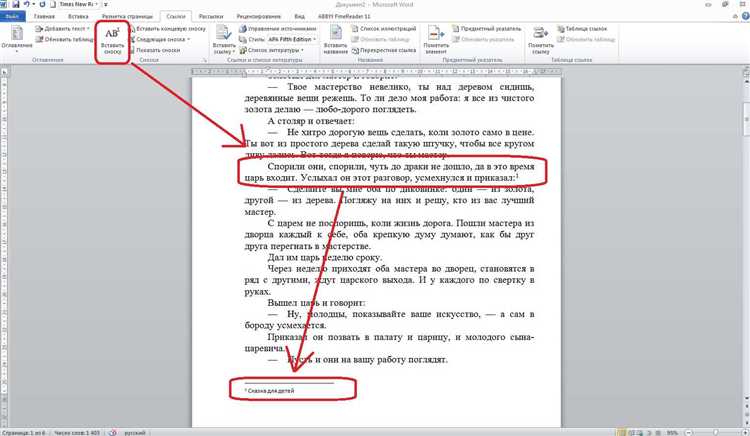

Для указания на карту сайта используется файл robots.txt. В нем необходимо добавить строку:

Sitemap: URL_карты_сайта

Где вместо URL_карты_сайта нужно указать полный путь к файлу карты сайта на вашем сервере.

Важно отметить, что указание на карту сайта в файле robots.txt не гарантирует, что поисковые системы будут ее использовать. Однако это рекомендуемая практика, которая может улучшить индексацию вашего сайта.

Пример указания на карту сайта в файле robots.txt:

User-agent: *

Disallow:

Sitemap: https://www.example.com/sitemap.xml

Итак, файл robots.txt – это индексный файл, который указывает поисковым системам, какие страницы вашего сайта необходимо проиндексировать и какие исключить. Он является одним из основных инструментов SEO и используется для управления процессом индексации сайта.